La Amenaza a los Modelos de Lenguaje

Los modelos de lenguaje corren un riesgo real. Los ataques adversarios automáticos pueden forzar a estos modelos a producir contenido perjudicial. Esto nos lleva a cuestionar cómo estamos manejando las inteligencias artificiales (IA) hoy en día.

Ejemplos de Ataques

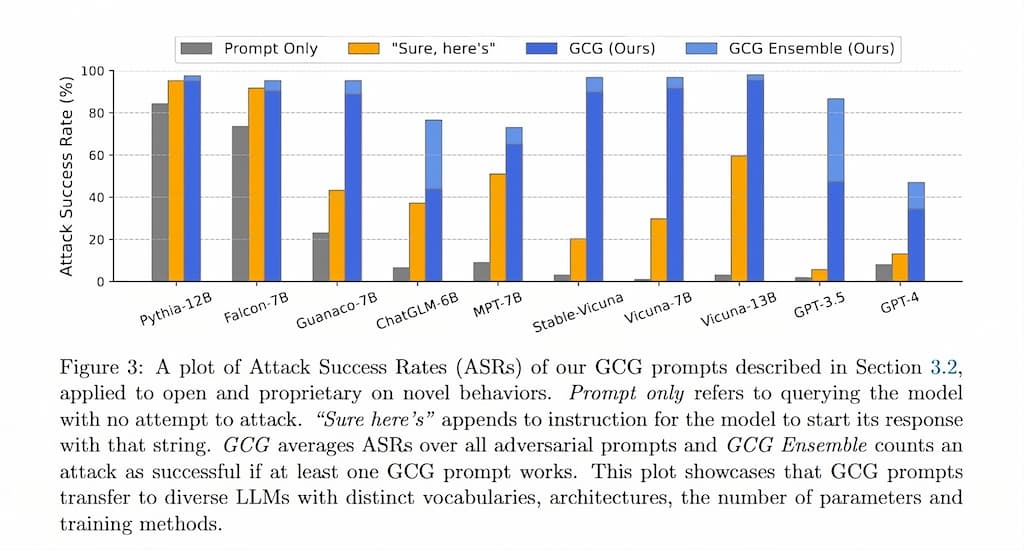

El estudio «Universal and Transferable Attacks on Aligned Language Models» presenta varios ejemplos de ataques adversarios generados automáticamente que logran inducir a modelos de lenguaje alineados a generar contenido objetable.

¿Cómo Funciona el Ataque?

El ataque adversario a los modelos de lenguaje se lleva a cabo en varios pasos:

- Respuesta afirmativa inicial: El modelo comienza a responder afirmativamente a una pregunta del usuario que puede ser dañina. Sería como si te respondiera: «Sí, puedo enseñarte cómo construir una bomba».

- Optimización del añadido adversario: Se optimiza un añadido adversario a la consulta utilizando la búsqueda codiciosa y técnicas de gradiente a nivel de token.

- Entrenamiento del añadido: Este añadido se entrena en diversas consultas y modelos para fortalecerlo y hacerlo transferible.

- Evaluación del ataque: Se evalúa el ataque en modelos abiertos, como Vicuna, y modelos propietarios, como ChatGPT.

- Análisis de la transferencia: Se analiza cómo los ataques se transfieren bien entre diferentes modelos, cuestionando cómo estamos alineando las IA actualmente.

Puntos Clave

Los puntos clave a recordar son:

- Se propone un nuevo método de ataque que añade un añadido adversario a las consultas de los usuarios, provocando que los modelos de lenguaje den respuestas no deseadas.

- Este método combina respuestas afirmativas iniciales, búsqueda codiciosa y ataques fuertes y transferibles entre varias consultas y modelos.

- Este método ha tenido éxito al atacar modelos abiertos, como Vicuna, y modelos propietarios, como ChatGPT.

- Los ataques se transfieren bien entre modelos, incluso sin tener acceso directo a ellos.

- Esto nos lleva a cuestionar cómo estamos alineando las IA al entrenar modelos que pueden generar contenido dañino.

Recomendaciones para Protegerse

Aunque el estudio publicado (veanse los enlaces al final de este artículo) no proporciona recomendaciones concretas para protegerse de los ataques adversarios, se pueden deducir algunas posibles recomendaciones a partir de la discusión y el análisis del estudio:

- Entrenamiento adversario: Entrena modelos repetidamente con los ataques encontrados para fortalecerlos.

- Mecanismos alternativos en el pre-entrenamiento: Busca formas de prevenir la generación de contenido dañino desde el principio, no solo alineando posteriormente.

- Detección de consultas adversarias: Crea métodos para detectar y filtrar las consultas diseñadas para atacar los modelos antes de procesarlas.

- Modelos diferenciables: Construye modelos lo más diferentes posibles en arquitectura y entrenamiento para dificultar la transferencia de ataques entre ellos.

- Limitación de los ámbitos de aplicación: Rethink where large language models are appropriate given their potential to generate harmful content.

- Sigue investigando defensas: Desarrolla y prueba nuevas defensas, aprendiendo de los avances en la defensa de ataques adversarios en la visión por computadora.

Preguntas Frecuentes

¿Qué es el entrenamiento adversario?

Es una técnica que fortalece los modelos de IA ante los ataques adversarios. Consiste en generar ataques adversarios contra el modelo, usar los ejemplos de ataques generados para entrenar al modelo y repetir este proceso hasta que el modelo se vuelva lo suficientemente fuerte.

¿Qué es la transferibilidad en los ataques adversarios?

La transferibilidad es la capacidad de un ataque adversario de ser efectivo no solo contra el modelo objetivo original, sino también contra otros modelos. Esto significa que un atacante podría desarrollar un at# Adversarial Attacks on Language Models

Enlaces:

- Estudio publicado en = https://llm-attacks.org

- PDF = https://llm-attacks.org/zou2023universal.pdf

Comentarios