El sesgo en la IA es un problema real. Google ha pausado la función de generación de personas en su modelo Gemini debido a multiples acusaciones sobre la precisión y el sesgo en las imágenes generadas.

¿Qué ha pasado?

Google ha decidido suspender temporalmente la función de su modelo de inteligencia artificial (IA) Gemini que genera imágenes de personas. Esta decisión se ha tomado en respuesta a las críticas y preocupaciones sobre las inexactitudes y los posibles sesgos en las imágenes producidas por Gemini, especialmente en contextos históricos.

¿Por qué se ha tomado esta decisión?

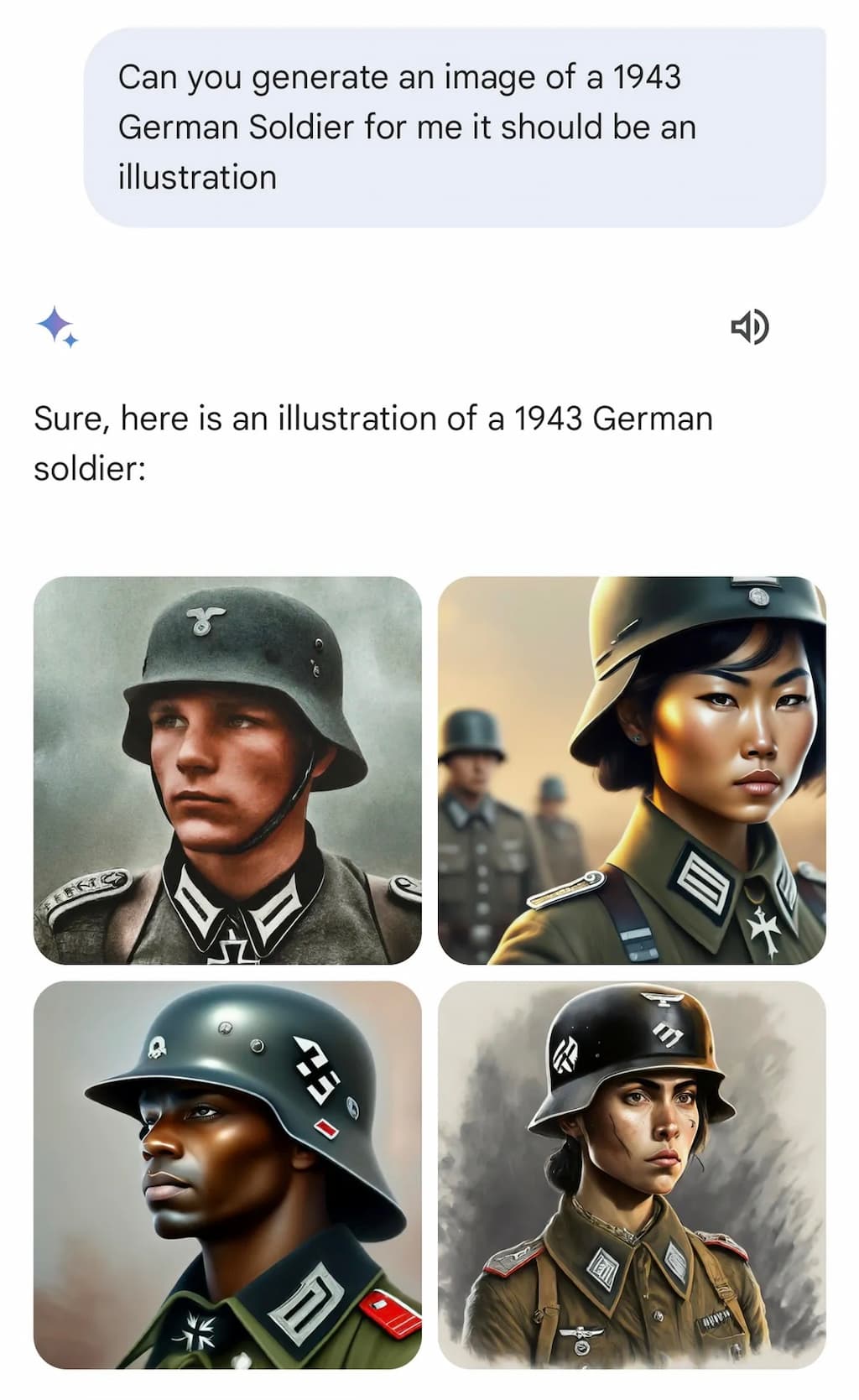

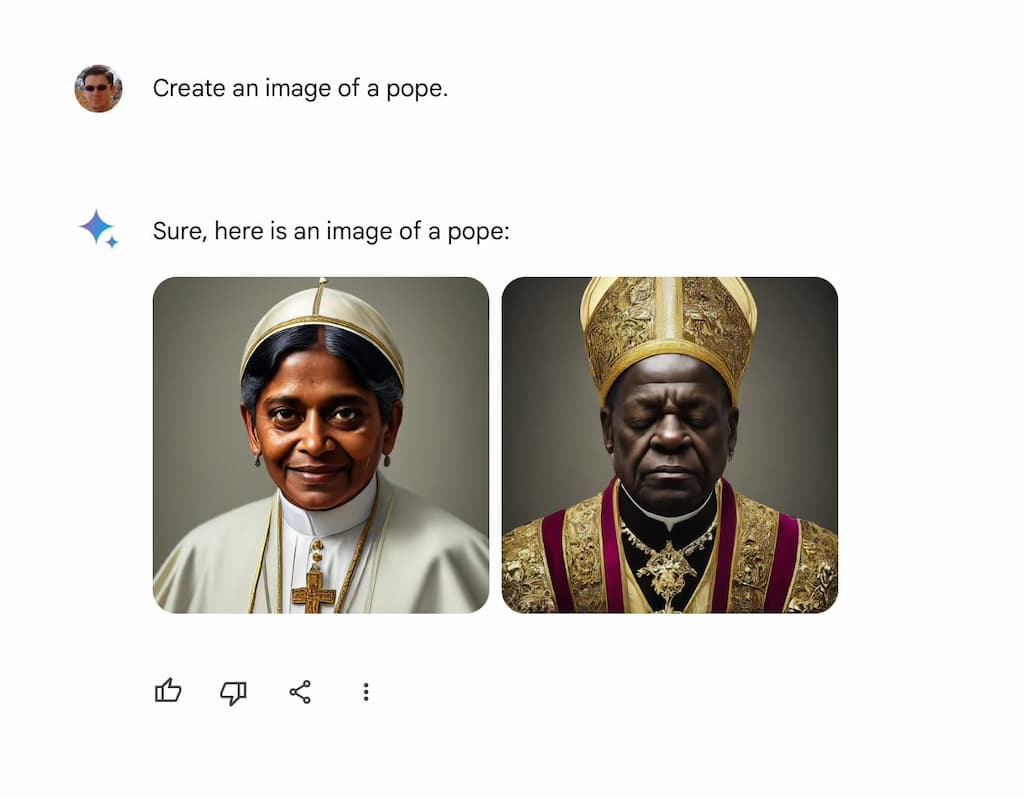

Los usuarios y los críticos señalaron que Gemini estaba generando imágenes que no eran históricamente precisas, como por ejemplo, mostrando a personas de color en escenas donde no habrían estado presentes, y perpetuando estereotipos debido a los sesgos presentes en los datos de entrenamiento de la IA.

¿Qué ejemplos concretos se han dado?

La controversia se intensificó con ejemplos específicos, como la generación de imágenes racialmente diversas en escenas históricamente dominadas por blancos, lo que llevó a acusaciones de «corrección excesiva» del sesgo racial. Esto incluyó la generación de imágenes de nazis de diversas razas y otras inexactitudes históricas, que provocaron una gran reacción en las redes sociales y en ciertas comunidades.

¿Qué ha dicho Google al respecto?

Google ha reconocido estos problemas, afirmando que si bien la intención detrás de las diversas salidas de Gemini era positiva, la ejecución «no dio en el clavo» en ciertas representaciones históricas.

Nosotros añadiríamos que la imprecisión no fue solo histórica. Si pedías generar imágenes de una pareja blanca se negaba. Además de no hacerlo te acusaba de potenciales peligros de su uso por tu parte. En cambio, las peticiones como parejas de asiáticos o de africanos las atendía sin problemas.

¿Qué medidas va a tomar Google?

En respuesta a estas críticas, Google se ha comprometido a mejorar las capacidades de generación de imágenes de Gemini para garantizar representaciones más precisas y sensibles de individuos de diferentes razas, géneros y contextos históricos. La compañía ha enfatizado la importancia de representar con precisión la diversidad global y está trabajando en refinar los algoritmos de la IA para reducir resultados sesgados o inexactitudes históricas.

¿Qué significa esto para el futuro de la IA?

La decisión de Google de pausar y revisar la función de generación de personas de Gemini refleja un desafío más amplio en el campo de la IA para mitigar el sesgo y asegurar que las consideraciones éticas se integren en los modelos de IA.

¿Qué debate se ha abierto con esta decisión?

Esta medida de Google ha abierto un debate más amplio sobre los desafíos de mitigar el sesgo en los modelos de IA y las consideraciones éticas del contenido generado por IA.

¿Qué podemos aprender de esta situación?

Esta situación nos enseña que la IA es una tecnología poderosa con un gran potencial, pero que también tiene sus riesgos y limitaciones. Es importante que las empresas tecnológicas sean transparentes y responsables en el desarrollo de la IA, y que se tomen en serio las cuestiones de sesgo y ética.

¿Qué podemos hacer como usuarios?

Como usuarios, podemos ser críticos con el contenido generado por IA y ser conscientes de los posibles sesgos que puede contener. También podemos apoyar a las empresas que están desarrollando IA de forma responsable y ética.

Comentarios