Todos sabemos que modelos de lenguaje como ChatGPT y Bard son muy buenos manejando lenguajes, pero no tanto con problemas matemáticos. TheoremQA es una clara mejora matemática para modelos de lenguaje.

Adentrémonos en el emocionante mundo de TheoremQA, el primer conjunto de datos basado en teoremas diseñado para evaluar las habilidades de los modelos de inteligencia artificial en la resolución de preguntas complejas en ciencias como las matemáticas, la física, la ingeniería eléctrica y la informática, y las finanzas.

¡Prepárate para descubrir cómo este revolucionario conjunto de datos está cambiando la forma en que evaluamos el rendimiento de los modelos de IA!

TheoremQA: Un desafío innovador para la IA

TheoremQA nace con el objetivo de poner a prueba la capacidad de los modelos de IA para aplicar teoremas en la resolución de problemas científicos desafiantes. Se trata de un conjunto de datos cuidadosamente seleccionado que contiene 800 preguntas de alta calidad que abarcan más de 350 teoremas en más de 30 subcampos.

Estas preguntas han sido diseñadas por expertos humanos para evitar la memorización durante el entrenamiento previo y permitir una evaluación automática de los modelos. TheoremQA busca evaluar cómo los modelos de lenguaje de última generación, como GPT-4 y PaLM-2, pueden aplicar conocimientos específicos del dominio (es decir, teoremas) para resolver problemas matemáticos más desafiantes.

GPT-4 y PaLM-2 frente a TheoremQA

Si bien los modelos de IA como GPT-4 y PaLM-2 han demostrado un rendimiento casi perfecto en conjuntos de datos de matemáticas de nivel escolar, sus habilidades para enfrentarse a problemas STEM más desafiantes, como aquellos que requieren teoremas específicos, no se habían investigado a fondo.

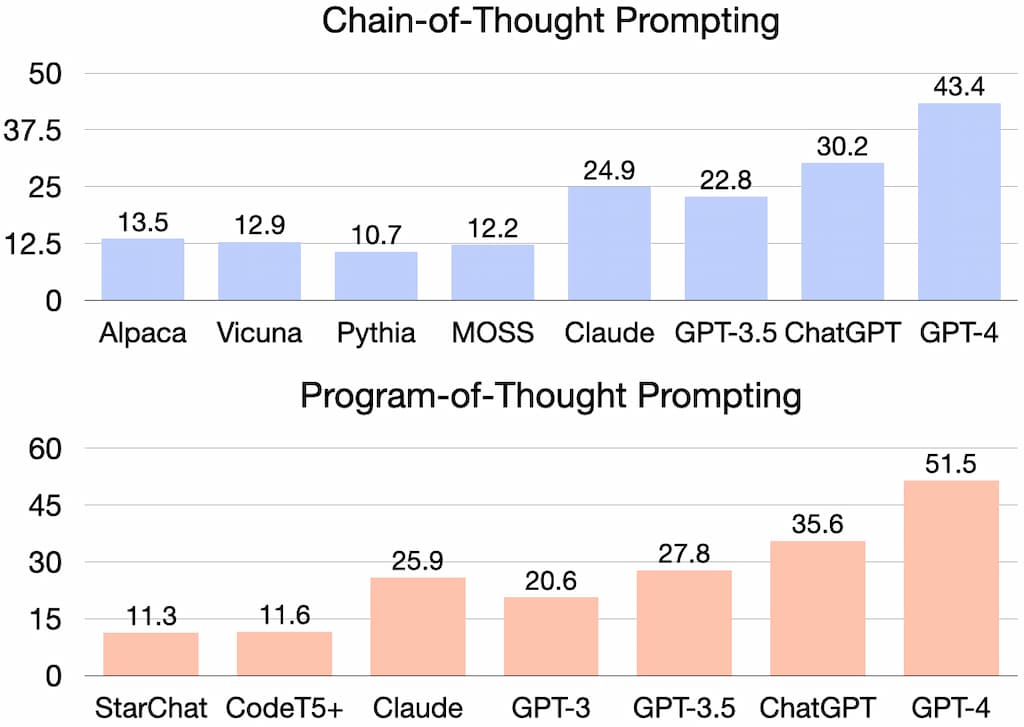

Al evaluar a GPT-4 en TheoremQA utilizando técnicas de «Chain-of-Thought prompting» y «Program-of-Thought Prompting», los investigadores descubrieron que GPT-4 logró un impresionante 51% de precisión con PoT y 43% con CoT. En comparación, otros modelos de IA de código abierto obtuvieron solo entre un 10% y un 14% de precisión.

TheoremQA Results

El «Chain-of-Thought prompting» es una técnica que se enfoca en generar respuestas coherentes y relevantes al proporcionar al modelo una secuencia de pensamiento o contexto para guiar la generación de respuestas. Esta técnica permite que los modelos de lenguaje grande descompongan problemas de múltiples pasos en pasos intermedios de razonamiento, mejorando así su capacidad para realizar razonamientos complejos.

El «Chain-of-Thought prompting» ha demostrado mejorar el rendimiento de los modelos de lenguaje en tareas de razonamiento aritmético, de sentido común y simbólico.

Por otro lado, el «Program-of-Thought Prompting» o «Program of Thoughts» (PoT) es una propuesta para desentrañar la computación del razonamiento en tareas de razonamiento numérico.

Según la evaluación humana, GPT-4 aplicó correctamente el teorema en la mayoría de los casos y su comprensión de los teoremas fue en gran medida correcta. La mayoría de los errores cometidos por GPT-4 se debieron a pequeños errores en los cálculos, pero esto no afectó significativamente su actuación global.

Como dijo Isaac Newton: «Si he visto más lejos, es porque estoy sentado en hombros de gigantes«. GPT-4 muestra un avance significativo en la aplicación de teoremas para resolver problemas desafiantes, pero aún queda mucho por hacer para cerrar la brecha entre los modelos de IA y la comprensión humana de conceptos más avanzados.

Explora TheoremQA por ti mismo

Si te interesa profundizar en TheoremQA y sus aplicaciones en la evaluación de modelos de IA, visita el repositorio de GitHub en https://github.com/wenhuchen/TheoremQA. Allí encontrarás los datos y el código para empezar a experimentar por ti mismo.

Reflexiones finales

TheoremQA es un emocionante paso adelante en la evaluación de las capacidades de los modelos de IA para aplicar conocimientos específicos del dominio en la resolución de problemas científicos complejos. A través de este conjunto de datos, podemos comenzar a comprender mejor cómo estos modelos pueden enfrentarse a desafíos más allá de las matemáticas básicas y cómo podemos continuar mejorando su rendimiento en aplicaciones más avanzadas y especializadas.

A medida que la inteligencia artificial sigue avanzando, es fundamental que sigamos desarrollando herramientas como TheoremQA para evaluar y mejorar la capacidad de los modelos de IA en una amplia variedad de campos. Solo entonces podremos aprovechar al máximo el potencial de estos «gigantes» y llevar el conocimiento humano a nuevas alturas.

Comentarios